L’intelligence artificielle (IA) pourra-t-elle un jour lire directement dans notre cerveau, y traquer nos pensées ? Une série de travaux récents suggère en tout cas que l’IA est en mesure de décoder et de traduire toujours mieux, sous forme de textes et d’images, notre activité cérébrale, lorsque nous écoutons un récit, voulons parler ou regardons des images. Les derniers en date, présentés mercredi 18 octobre par une équipe de Meta AI (ex-Facebook) à Paris, témoignent de façon spectaculaire de ces avancées.

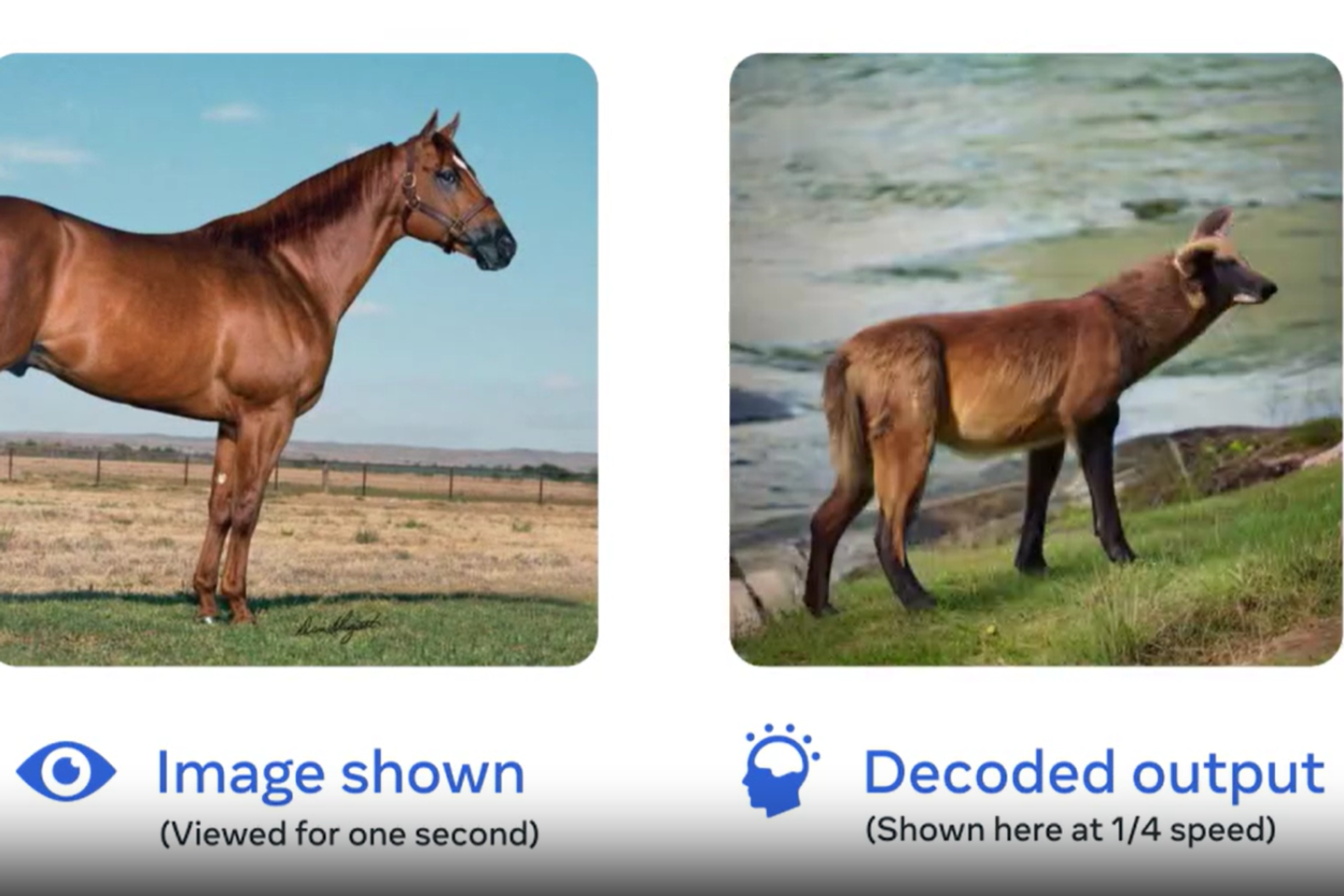

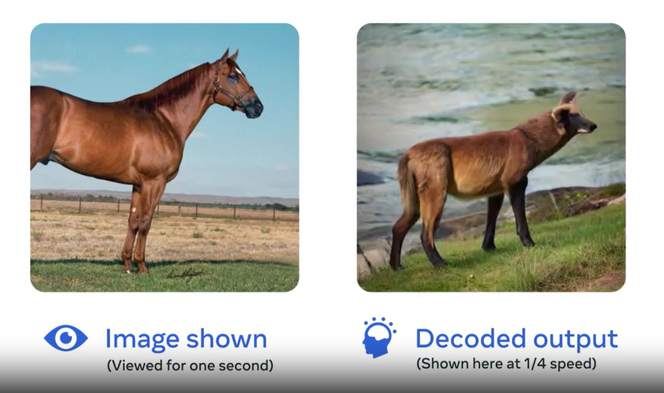

Jean-Rémi King et ses collègues décrivent comment leurs algorithmes d’IA sont parvenus à reproduire avec fidélité des photographies regardées par des volontaires en se fondant sur l’analyse de l’activité de leur cerveau. Leurs observations sont présentées dans un preprint – une publication non encore relue par les pairs avant publication dans une revue scientifique. Elles portent sur des jeux de données obtenues par magnétoencéphalographie (MEG) ou par imagerie par résonance magnétique fonctionnelle (IRMf) sur des volontaires à qui des photographies étaient projetées. Ces données ont ensuite été soumises à une série de décodeurs par l’IA qui ont appris à les interpréter et à les retranscrire en images.

Le résultat ? Si la ressemblance entre l’original et la copie n’est pas parfaite, les similitudes sont souvent frappantes : un zèbre se trouve revêtu d’un mélange de peau de vache et d’okapi, une petite fille au cerf-volant se retrouve avec un objet non identifié au-dessus de la tête, mais un surfeur semble prendre la même vague que son modèle, et un skieur en combinaison rouge conserve la même posture que l’original. Effet waouh garanti, « même pour les chercheurs de notre équipe, admet Jean-Rémi King, chercheur académique (CNRS, ENS) en détachement pour cinq ans à Meta AI. Il y a encore deux ans, je n’aurais pas pensé que ce type de résultat serait possible. »

Ces derniers mois, plusieurs publications, cette fois dans le domaine de la parole, avaient rappelé le potentiel de décodage de l’activité cérébrale par l’IA, que ce soit par des voies invasives – recueil de données par l’intermédiaire d’électrodes implantées dans le cerveau chez des personnes paralysées – ou non invasives, comme avec la MEG, l’IRMf, de grosses machines dans lesquelles la tête des sujets est plongée, mais aussi avec un simple bonnet pour les électroencéphalogrammes (EEG).

Le 1er mai, dans Nature Neuroscience, une équipe de l’université d’Austin (Etats-Unis), dirigée par Alexander Huth, décrivait avoir tenté de faire reproduire grâce à un décodeur d’IA de petites histoires entendues par des sujets placés dans une IRMf. L’expérience n’était pas totalement concluante, mais montrait que l’IA pouvait en partie retrouver les mots et le sens général. Elle pouvait aussi produire un texte à partir d’un récit imaginé par les volontaires, ou d’une vidéo qu’ils visionnaient. Une part du sens était préservée, avec une fidélité supérieure à un texte purement aléatoire. Comme si le cerveau, à travers ces diverses modalités – récit écouté, imaginé ou observé –, produisait « un code neural partagé entre le visuel et la parole », commente Jean-Rémi King.

Il vous reste 65% de cet article à lire. La suite est réservée aux abonnés.